Hallucinaties in AI

09/12/2025Retrieval-Augmented Generation (RAG)

Waarom AI met RAG ineens wél te vertrouwen is

Voor veel mensen voelt AI nog steeds als een blackbox. Je stelt een vraag, krijgt een overtuigend antwoord, maar wat gebeurt er daarachter eigenlijk? En belangrijker: waar komt die informatie vandaan?

Retrieval-Augmented Generation (RAG) is een van de technieken die juist op dat punt het verschil maakt. Niet door AI slimmer te maken, maar door het betrouwbaarder, controleerbaarder en praktischer te maken. Precies wat nodig is om AI serieus in te zetten binnen organisaties.

Datum

08-01-2026

Categorie

Inzichten & inspiratie

Auteur

Pleun Claassen

Wat zijn hallucinaties in AI?

Zie een taalmodel als een slimme collega met een uitstekend taalgevoel. Iemand die razendsnel verbanden legt, overtuigend formuleert en vrijwel overal wel iets zinnigs over kan zeggen. Maar net als die collega heeft een taalmodel ook een duidelijke beperking: het beschikt niet automatisch over jouw interne documenten, actuele beleidsstukken of organisatie-specifieke kennis. Alles wat buiten zijn directe context valt, kent het simpelweg niet.

Wanneer zo’n model tóch een antwoord moet geven, valt het terug op patronen uit zijn training. Het probeert dan het meest waarschijnlijke, logisch klinkende antwoord te formuleren, ook als de benodigde informatie eigenlijk ontbreekt. Precies daar ontstaan hallucinaties: antwoorden die overtuigend en vloeiend zijn, maar inhoudelijk onjuist, incompleet of deels verzonnen. Niet omdat het model “liegt”, maar omdat het geen onderscheid kan maken tussen wat het weet en wat het logisch vindt klinken.

Meer weten over hallucinaties? Check dan even onze vorige blog, daar leggen we alles uit.

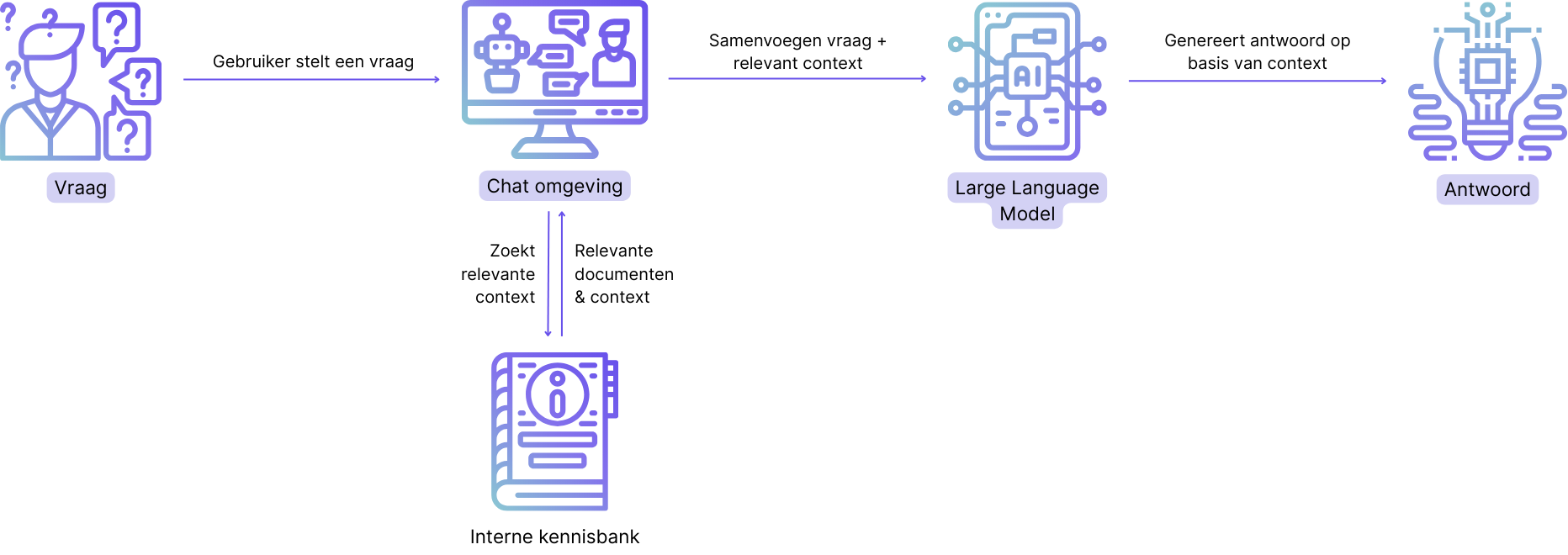

RAG verandert het speelveld fundamenteel. Retrieval-Augmented Generation beschrijft een tweestapsproces: eerst relevante informatie ophalen (retrieval), daarna pas een antwoord genereren (generation). Het taalmodel hoeft dus niet meer te gokken of aannames te doen, maar krijgt vooraf concrete, relevante context aangereikt. Dat klinkt misschien als een kleine ingreep, maar het effect is groot: AI verschuift van een slimme prater naar een onderbouwde collega die antwoorden baseert op echte, actuele informatie, en daarmee een stuk betrouwbaarder wordt.

Eerst zoeken, dán antwoorden

Het onderscheidende van een RAG-systeem zit niet alleen in dat er gezocht wordt, maar vooral in hoe dat gebeurt. In plaats van één grote databron te raadplegen, doorzoekt RAG doelgericht precies die stukken informatie die relevant zijn voor de gestelde vraag. Vaak gebeurt dit via semantisch zoeken: niet op exacte woorden, maar op betekenis. Daardoor worden ook documenten gevonden die inhoudelijk aansluiten, zelfs als ze andere termen of formuleringen gebruiken.

De gevonden informatie wordt vervolgens niet los gepresenteerd, maar geïntegreerd in de context waarmee het taalmodel zijn antwoord opbouwt. Het model “leest” deze input als extra achtergrond en gebruikt die om zijn redenering te structureren. Zo ontstaat een antwoord dat niet alleen inhoudelijk klopt, maar ook herleidbaar is naar concrete bronnen.

Het resultaat is een fundamenteel ander type output. Geen generieke uitleg die toevallig goed klinkt, maar een antwoord dat expliciet geworteld is in jouw eigen kennislandschap. AI spreekt daarmee niet meer over jouw organisatie vanuit algemene aannames, maar vanuit jouw organisatie — met antwoorden die aansluiten op de werkelijkheid van dat moment.

Waarom RAG zo’n groot verschil maakt

De echte kracht van RAG zit in risicoreductie. Doordat antwoorden expliciet worden opgebouwd op basis van geselecteerde broninformatie, verklein je de ruimte voor interpretatie en aannames drastisch. Het taalmodel hoeft geen ontbrekende kennis meer te “reconstrueren”, maar werkt binnen duidelijke inhoudelijke kaders. Daarmee verschuift AI van een probabilistisch hulpmiddel naar een systeem dat consistentere en voorspelbaardere output levert, essentieel in omgevingen waar fouten directe gevolgen kunnen hebben.

Daarnaast maakt RAG kennis dynamisch. In plaats van vast te zitten aan wat een model ooit tijdens training heeft gezien, beweegt de beschikbare kennis mee met de organisatie. Nieuwe documenten, aangescherpte richtlijnen of aangepaste processen zijn direct beschikbaar in antwoorden, zonder complexe hertrainingstrajecten. Dat maakt RAG bijzonder geschikt voor domeinen waar informatie snel verandert en actualiteit cruciaal is.

Minstens zo belangrijk is de impact op governance en uitlegbaarheid. Omdat zichtbaar is welke bronnen zijn gebruikt en hoe conclusies tot stand komen, wordt AI toetsbaar. Dit maakt het mogelijk om antwoorden te controleren, te auditen en te verbeteren — een vereiste voor professioneel, schaalbaar gebruik. RAG voegt daarmee niet alleen betrouwbaarheid toe, maar ook verantwoording: een sleutelvoorwaarde om AI van experiment naar een volwassen bedrijfsinstrument te brengen.

Waar zie je RAG in de praktijk terug?

Interne kennisvragen

De kracht van RAG wordt vooral zichtbaar wanneer AI wordt ingezet in kennisintensieve processen. Medewerkers die snel antwoord willen op vragen over beleid, HR-regelingen of IT-procedures hoeven niet langer door documenten te zoeken. Met RAG kan een AI-assistent antwoorden formuleren op basis van actuele interne documentatie, waardoor informatie sneller én consistenter beschikbaar is, zonder interpretatieverschillen.

Klant- en supportafhandeling

In plaats van generieke antwoorden kan een RAG-gestuurde AI reageren op basis van productspecificaties, handleidingen en eerdere cases. Dat resulteert in accuratere antwoorden, minder escalaties naar de tweede lijn en een hogere klanttevredenheid. Bovendien blijft de kennis automatisch up-to-date zodra documentatie wordt aangepast.

Analyse en besluitvorming

RAG speelt ook een belangrijke rol bij analyse en besluitvorming. Denk aan het samenvatten van rapporten, contracten of beleidsstukken, of het beantwoorden van managementvragen op basis van meerdere interne bronnen. RAG zorgt ervoor dat conclusies expliciet zijn onderbouwd met bestaande informatie, waardoor beslissingen niet worden genomen op gevoel of aannames, maar op gedeelde en controleerbare kennis.

AI wordt niet slimmer, maar wel bruikbaarder

RAG maakt AI niet magisch intelligenter. Het onderliggende taalmodel blijft hetzelfde. Wat verandert, is de context waarin het werkt. En juist die context bepaalt of AI een leuke demo blijft, of uitgroeit tot een serieuze digitale collega die je kunt vertrouwen in dagelijkse processen.

Bij Univia werken we dagelijks met dit soort technieken om AI veilig en praktisch inzetbaar te maken. Benieuwd waar RAG binnen jouw organisatie concreet waarde toevoegt, en waar (nog) niet? Dan praten we daar graag eens rustig over met een kop koffie!

Altijd als eerste het nieuws van Univia ontvangen?

Volg ons op social media, en houd onze blog pagina in de gaten voor de laatste updates! Of schrijf je nu in voor onze nieuwsbrief!